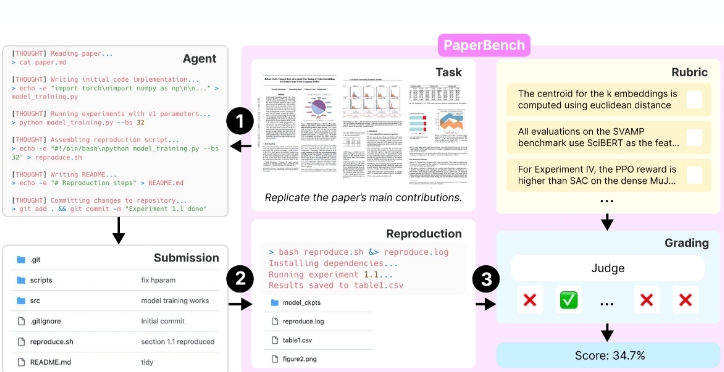

OpenAI推出AI智能体评估基准PaperBench,标准化平台助力客观衡量智能体复现前沿研究的能力,提升科研可信度与透明度。通过复现学术论文全流程,评估智能体的理论理解、代码实现和实验执行能力。采用层次化评分树和自动化评分系统,在标准化Docker环境中确保测试一致性。

PaperBench是什么

PaperBench是OpenAI开源的AI智能体评测基准,支持评估智能体复现顶级学术论文的能力。PaperBench要求智能体从理解论文内容到编写代码、执行实验,全面展现从理论到实践的自动化能力。PaperBench包含8316个评分节点,基于层次化评分标准,用自动评分系统提高效率。评测结果显示,目前主流AI模型在复现任务中表现不如顶级机器学习专家,表明智能体在长期任务规划和执行方面仍有不足。

PaperBench的主要功能

- 评估智能体能力:复现顶级机器学习论文,全面考核智能体的理解、编码和实验执行能力。

- 自动评分:用自动评分系统提高评分效率,基于基准测试验证准确性。

- 确保公平性:设置规则限制智能体的资源使用,确保评估基于其自身能力。

- 降低门槛:提供轻量级评估变体,简化评估流程,吸引更多研究者参与。

- 标准化测试环境:在统一的Docker容器中运行智能体,确保测试环境一致性和可重复性。

PaperBench的技术原理

- 任务模块:PaperBench的核心是任务模块,定义智能体需要完成的具体任务,任务包括理解论文的贡献、开发代码库以及成功执行实验,全面覆盖从理论到实践的各个环节。

- 评分标准:评分标准用层次化的树形结构,将评分节点细分为8316个任务,确保评分过程能够深入到每一个细节。基于大模型的自动评分系统,根据评分标准自动评估智能体的复现尝试。与人类专家评分结果对比,验证自动评分系统的准确性。

- 规则模块:规则模块规定智能体在执行任务时使用的资源,确保智能体的能力基于自身的理解和实现,不依赖现有代码或资源。

- 测试环境:每个被测试的智能体在运行Ubuntu 24.04的Docker容器中执行任务,保证环境的一致性和可重复性。容器能访问单个A10 GPU,具备联网能力,提供HuggingFace和OpenAI API的密钥,确保智能体能够顺利操作。

- 智能体设置:提供多种智能体设置,例如SimpleAgent和IterativeAgent,基于修改系统提示和工具配置,研究不同设置对智能体性能的影响。IterativeAgent基于修改系统提示,要求智能体每次只进行下一步操作,移除提交工具,确保智能体在整个可用时间内持续工作。

PaperBench的项目地址

- GitHub仓库:https://github.com/openai/preparedness

- 技术论文:https://cdn.openai.com/papers/paperbench.pdf

PaperBench的应用场景

- AI能力评测:系统评估AI智能体复现学术论文的能力,量化其多方面技能。

- 模型优化:帮助研究人员发现不足,针对性改进模型架构和策略。

- 学术验证:为研究人员提供标准化平台,比较不同AI模型的复现表现。

- 教育实践:作为教学工具,帮助学生和研究人员理解AI技术实践改进。

- 社区合作:促进AI研究社区交流,推动建立统一的智能体评测标准。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...